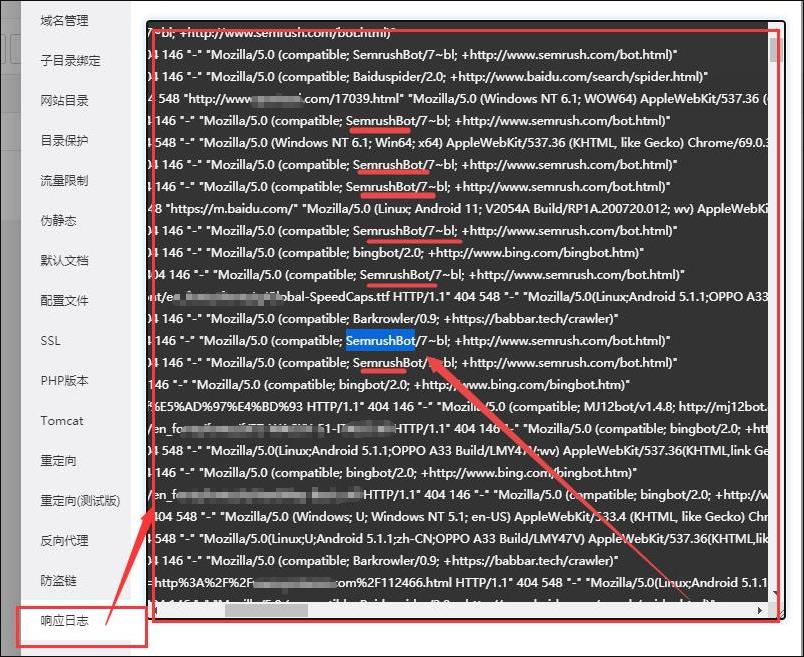

品自行博客今天查看服务器发现近期负载特别高,因为是Linux宝塔面板,服务器经过调试了的,流量也没有异常,所以打开网站日志查找原因,发现一些垃圾蜘蛛频繁抓紧网站页面,白白浪费服务器资源。

我们知道一般百度、google、搜狗、360的蜘蛛抓取都是正常的抓取,如果这几个搜索引擎之外的蜘蛛对我们的网站进行频繁抓取的话就得注意了,这些抓取会消耗我们网站的资源,对服务器形成压力,所以要屏蔽一些垃圾蜘蛛的抓取,这里介绍两种方法进行屏蔽:

第一种方法:直接在根目录下robos.txt文件里面屏蔽掉相关垃圾蜘蛛:

第二种方法,如果是Linux宝塔面板,可以进面板,选择“网站”》“设置”》“配置文件”,将需要屏蔽的蜘蛛写进配置文件的代码中:

#屏蔽垃圾蜘蛛 if ($http_user_agent ~* (SemrushBot|DotBot|MJ12bot|AhrefsBot|MauiBot|MegaIndex.ru|BLEXBot)) { return 403; }

- SemrushBot,这是semrush下面的一个蜘蛛,是一家做搜索引擎优化的公司,因此它抓取网页的目的就很明显了。这种蜘蛛对网站没有任何用处,好在它还遵循robots协议,因此可以直接在robots屏蔽。

- DotBot, 这是moz旗下的,作用是提供seo服务的蜘蛛,但是对我们并没有什么用处。好在遵循robots协议,可以使用robots屏蔽

- AhrefsBot, 这是ahrefs旗下的蜘蛛,作用是提供seo服务,对我们没有任何用处,遵循robots协议。

- MJ12bot,这是英国的一个搜索引擎蜘蛛,但是对中文站站点就没有用处了,遵循robots协议。

- MauiBot,这个不太清楚是什么,但是有时候很疯狂,好在遵循robots协议。

- MegaIndex.ru,这是一个提供反向链接查询的网站的蜘蛛,因此它爬网站主要是分析链接,并没有什么作用。遵循robots协议。

- BLEXBot, 这个是webmeup下面的蜘蛛,作用是收集网站上面的链接,对我们来说并没有用处。遵循robots协议

- 等等、、、、

主要是将从网站日志中发现的一些异常抓取的蜘蛛屏蔽掉,我上面列举的是一些常见的对我们网站没啥用处的蜘蛛,将这些蜘蛛屏蔽掉就好了。

评论